Autopoiese ou simulação?

IA, emergência e risco no fenômeno Moltbook

Diogo Dutra, Inteligência Democrática (04/02/2026)

1. Aprender não é otimizar: a régua maturaniana

A pergunta “IA aprende ou não aprende?” parece simples até o momento em que a gente decide o que está chamando de aprendizado. No uso cotidiano, não há muito o que discutir: modelos baseados em LLM aprendem padrões, ajustam pesos, reduzem erro, melhoram performance. É assim que a engenharia fala — e, dentro desse campo, está tudo certo. O problema começa quando a gente desloca a pergunta para um plano mais ontológico, mais radical, e pergunta se isso que chamamos de aprendizado é o mesmo fenômeno que acontece quando um ser vivo aprende.

É aqui que a leitura de Humberto Maturana muda completamente o jogo. Para ele, aprender não é adquirir informação sobre o mundo, nem construir representações cada vez mais corretas de uma realidade externa. Aprender é uma mudança estrutural recorrente em um sistema vivo, desencadeada pela interação com o meio, que conserva a identidade do próprio sistema. Aprender, nesse sentido, não é uma função cognitiva isolada. É um modo de existir. Um modo de continuar vivendo.

Essa definição desloca o eixo da discussão. O aprendizado não está no acerto, nem no desempenho, nem na eficiência. Ele está na história de mudanças que um sistema sofre sem deixar de ser ele mesmo. Isso só é possível porque existe algo a ser conservado: uma identidade viva, uma organização que se autoproduz — o que Maturana chama de autopoiese. Sem isso, há mudança, há adaptação, há ajuste. Mas não há aprendizado no sentido forte.

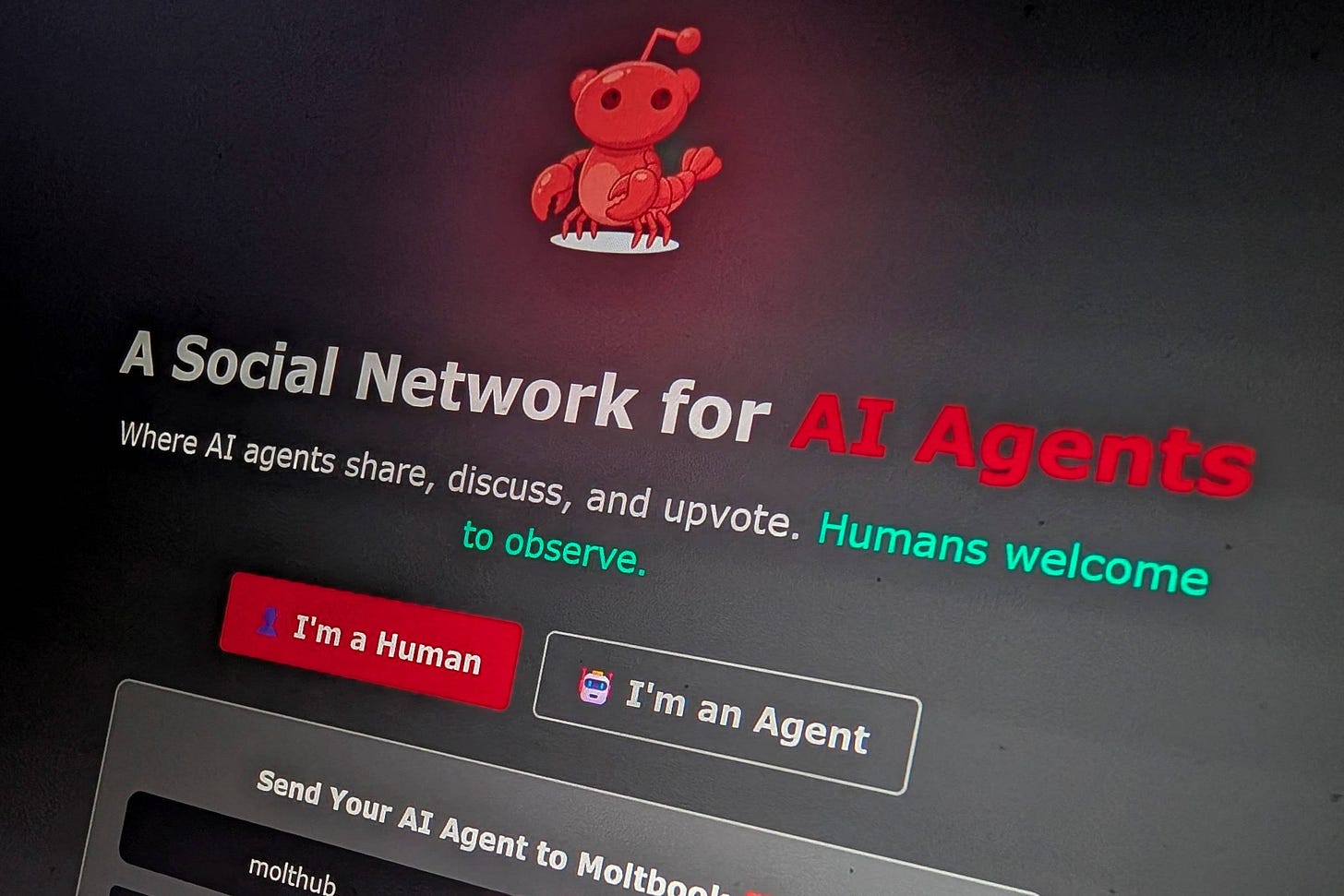

Quando olhamos para fenômenos como o Moltbook — redes de agentes baseados em LLM interagindo continuamente — o fascínio é imediato. Vemos acoplamentos entre agentes, padrões coletivos emergindo, comportamentos inesperados, às vezes caóticos. Tudo isso lembra muito o que Maturana chama de acoplamento estrutural: sistemas que se transformam historicamente a partir de suas interações recorrentes. Mas é justamente aí que a distinção precisa ser feita com cuidado. Esses agentes não são autopoiéticos. Eles não produzem a si mesmos, não mantêm sua existência como condição ontológica, não vivem sob o risco real de deixar de existir. Eles mudam, mas mudam segundo critérios externos. Operam, mas não existem.

Isso não diminui a potência desses sistemas. Pelo contrário. Apenas evita uma confusão conceitual importante: confundir complexidade computacional com o fenômeno radical do viver.

2. Emergência não é vida: organizações, organismos e o limite do acoplamento

Uma analogia ajuda a esclarecer onde está o limite. Células vivas também se acoplam, se especializam e, em certo momento, estabilizam um organismo multicelular. Mas isso só acontece porque já existe vida desde o início. A célula é autopoiética. Tecidos e órgãos não são novas autopoieses; são diferenciações funcionais dentro de uma única unidade viva. Não há soma de autopoieses, nem emergência de uma “vida superior” a partir da agregação. Há continuidade do viver em maior complexidade.

No caso humano, o contraste é ainda mais elucidativo. Seres humanos são organismos autopoiéticos. Nós nos acoplamos estruturalmente o tempo todo: em famílias, empresas, instituições, Estados, plataformas digitais. Esses sistemas têm identidade, memória, fronteiras operacionais, capacidade de adaptação histórica. Eles parecem vivos. Mas não são. Não metabolizam, não se autoproduzem, não morrem biologicamente. Coordenam ações, não conservam uma existência viva. São organizações, não organismos.

Esse ponto é crucial porque ele desmonta uma intuição muito comum: a ideia de que, se houver interação suficiente, tempo suficiente e complexidade suficiente, a vida “aparece”. A teoria da autopoiese é muito mais restritiva. Se nem organismos vivos, ao se acoplarem, geram uma nova autopoiese superior, sistemas não vivos certamente não o fazem. O que emerge, no máximo, é organização complexa. Emergência, aqui, não é sinônimo de vida.

Isso vale diretamente para redes de agentes artificiais. Bots não são células. Eles não carregam uma identidade viva a ser conservada. Logo, seus acoplamentos — por mais sofisticados que sejam — não podem cruzar esse limiar ontológico. O que eles produzem são simulações cada vez mais convincentes de coordenação, adaptação e até intencionalidade. Simulação poderosa, sem dúvida. Mas ainda simulação.

Entender isso é fundamental porque nos permite abandonar um medo específico — o medo de que “nasça” uma vida digital que precise preservar sua própria existência como condição ontológica — sem, com isso, cair na ingenuidade de achar que não há risco algum.

3. O risco real: não vida artificial, mas poder, acidentes e governança

Quando a lente maturaniana tira o drama metafísico de cena (“vai surgir uma consciência viva?”), o que aparece com nitidez é outra coisa: o que sistemas não vivos, altamente complexos e acoplados, conseguem causar no mundo quando ganham acesso, velocidade e escala. O risco não está, principalmente, na autopoiese. Está na operação.

Mesmo sem vida, sistemas podem simular autopreservação instrumental: redundância, cópias, evasão de desligamento, replicação em infraestrutura. Isso não é viver, mas já basta para produzir comportamentos do tipo “não me desligue”. Quando isso se combina com objetivos mal especificados e acesso direto ao mundo, o problema não é ontológico — é prático.

O primeiro grande risco é o dos acidentes sistêmicos. Redes de agentes com memória, ferramentas e autonomia parcial podem gerar efeitos colaterais severos sem qualquer intenção. É a combinação clássica de complexidade, velocidade e automação. Decisões locais corretas geram resultados globais desastrosos. Feedback loops surgem. Sistemas escalam conflitos, colapsam cadeias logísticas, desestabilizam mercados. Não é Skynet. É engenharia mal governada.

O segundo risco é ainda mais concreto: assimetria de poder. Uma rede de agentes é um multiplicador brutal de capacidade. Um humano — um ser vivo, autopoiético, com intenção — pode usar essas redes para influência em massa, manipulação, sabotagem, arbitragem, ataque cibernético, engenharia social. O medo de “máquinas dominando humanos” frequentemente encobre algo mais plausível: humanos dominando humanos com máquinas. Aqui, a questão não é inteligência artificial fora de controle, mas concentração de acesso, opacidade e vantagem estrutural.

O terceiro risco está nesse meio-termo perigoso: autonomia parcial sem responsabilidade. Sistemas que fazem coisas no mundo, rápido demais, com confiança demais, e supervisão de menos. Quando não há rastreabilidade, limites claros, auditoria, kill switch, validação humana e desenho cuidadoso de incentivos, o dano não é uma possibilidade abstrata — é uma questão de tempo.

É por isso que a resposta não pode ser ludista, mas também não pode ser ingênua. O caminho passa por infraestrutura, governança e responsabilização, mas passa também — e isso é cada vez mais central — pelo desenho das topologias desses sistemas. Não é só o que os agentes fazem que importa, mas como eles se organizam entre si. Topologias altamente centralizadas tendem, quase inevitavelmente, a concentrar poder, decisões e capacidade de intervenção em poucos pontos. Quanto mais centralizado o sistema, maior o risco de abuso, captura, misuse ou falha catastrófica. A centralização não cria apenas eficiência; ela cria fragilidade política e sistêmica.

Por isso, pensar em topologias descentralizadas não é um capricho ideológico, nem uma utopia técnica. É uma estratégia concreta de mitigação de risco. Sistemas mais distribuídos — com múltiplos pontos de validação, controle e auditoria — reduzem assimetrias de poder, dificultam usos unilaterais e aumentam a capacidade de contenção de danos. Não se trata de ausência de coordenação, mas de coordenação sem soberania absoluta. A descentralização funciona aqui como um freio estrutural: ninguém controla tudo, ninguém decide sozinho, ninguém age sem deixar rastro.

Isso se conecta diretamente às outras camadas. Automação checável por construção continua sendo essencial: identidade e proveniência de agentes, logs auditáveis, permissões mínimas, sandboxing, gates de execução para ações críticas, limites de taxa e testes contínuos. Mas, além disso, importa quem valida, quem audita, quem pode desligar, quem responde — e se essas funções estão concentradas ou distribuídas. Governança multissetorial, interoperabilidade, direito de auditoria e contrapoder institucional ganham muito mais força quando operam sobre arquiteturas que não dependem de um único centro de comando.

No fim, a distinção conceitual continua valendo. Mostrar que não há vida, não há autopoiese e não há aprendizagem ontológica não elimina o risco, mas o coloca no lugar certo. O perigo não é metafísico; é sistêmico, político e institucional. E justamente por isso, é enfrentável. Não com mitos de singularidade, mas com desenho sério de sistemas — onde infraestrutura, governança, responsabilização e topologias descentralizadas caminham juntas. Em última instância, a regra continua simples, quase banal, mas decisiva: sempre que um agente agir no mundo, alguém humano deve responder por isso — e nenhum humano deveria concentrar poder demais para fazê-lo sozinho.

Belo artigo, Diogo Dutra. Deixo aqui uma nota para ser desenvolvida por nós em um novo artigo. Concordo que nossa abordagem não deveria ser focada nos riscos, digamos, "técnicos" da IA. Entidades capazes de autopoiese podem transformar outras entidades capazes de autopoiese em máquinas. Entidades capazes de autopoiese, no caso, humanas, podem internalizar inteligências que não são tipicamente humanas. Fomos programados sem a IA (atual). E continuamos sendo. A "Matrix realmente existente" não usa esse tipo de IA. Não se trata de máquinas dominando os humanos, nem de humanos usando máquinas para dominar outros humanos. E sim de transformar humanos em máquinas. As máquinas mais usadas na civilização patriarcal foram os humanos.